摘 要: 首先提出一種運動人體檢測算法,通過圖像序列識別出運動人體作為跟蹤目標,然后在TLD算法中引入目標軌跡預測,利用該信息來輔助空間搜索。運動人體檢測算法首先采用背景減除和邊緣檢測算法獲得完整目標輪廓,然后使用HU仿射不變矩檢測出運動人體,該特征能適應目標旋轉、尺度、仿射等變化場合。為提高跟蹤實時性,在TLD框架中引入卡爾曼軌跡預測,并先在預測位置鄰域搜索。實驗結果表明,該運動人體檢測算法能夠在靜態和動態背景下準確地檢測出運動人體;改進后的TLD算法與原始算法相比,在準確率不降低情況下,降低了計算復雜度。

關鍵詞: 背景減除;人體檢測;邊緣檢測;卡爾曼濾波器;TLD

0 引言

近幾年,行人目標跟蹤成為計算機視覺領域的研究熱點之一,在智能監控、無人駕駛等領域有著重要應用。由于姿態變化、局部遮擋等問題未被徹底解決,該方向仍然具有很大的挑戰性。

對于目標檢測,DALAL N和TRIGGS B[1]提出一種HOG特征結合支持向量機(SVM)進行分類方法,具有較高準確率,但僅適用于無遮擋且姿態變化較小的場景。FELZENSZWALB P等人提出Deformable Part Models(DPM)[2-3]算法,用根及部件模型描述目標,能夠解決姿態變化和遮擋,但其計算復雜度高,實時性有待改善。由KALAL Z等人[4]提出的TLD跟蹤算法將跟蹤與檢測分離并融合二者結果,在線更新模板,解決目標重入且魯棒性較好,但漂移和遮擋問題未解決,僅適用于目標姿態漸變較慢的場景。

本文首先提出一種運動人體檢測算法初始化跟蹤目標,然后在TLD框架中引入卡爾曼濾波器[5]進行目標位置預測,優先在預測位置鄰域內搜索,從而減少搜索空間。

1 運動人體檢測

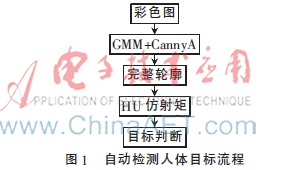

本文首先使用混合高斯模型(GMM)[6]獲得前景運動目標,然后提取輪廓區域特征進行目標判斷。處理流程如圖1所示。

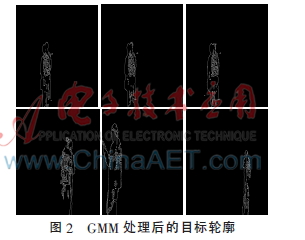

按照圖1的流程,在使用GMM處理后,僅尋找滿足面積和寬高比(0.4)且符合上下文空間關系的輪廓,結果如圖2所示。

1.1 獲得完整輪廓

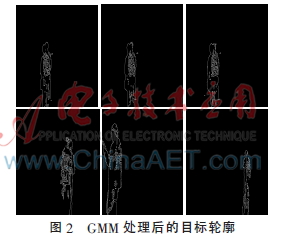

為去掉影子干擾,對目標區域使用中值濾波、開閉操作、Canny[7]檢測,對圖2處理后,結果如圖3所示。

1.2 計算目標輪廓特征

為適應目標輪廓各種變化,選取基于HU不變矩[8]得到F1、F3特征,用于判斷是否為人體。

![N5O2{0AQ)1)2E]F_3MSQE)3.png N5O2{0AQ)1)2E]F_3MSQE)3.png](http://files.chinaaet.com/images/2016/02/21/6359166544474400002122588.png)

其中,![CXHTM4]R1_RI@U9V385D[TR.png CXHTM4]R1_RI@U9V385D[TR.png](http://files.chinaaet.com/images/2016/02/21/6359166546021400002610049.png) 。

。

本文選擇7張人體(包括正面、背面、側面、不同尺度)與7張非人體圖做輪廓特征對比,結果如圖4所示,其中橫坐標為樣本編號,縱坐標為其特征值。

圖4中直線代表該特征均值,人體輪廓特征為圖中懸浮最上折線,另一條為非人體特征。從圖4中看到人體輪廓F1、F3特征值集中于某個區間,與非人體輪廓特征值有明顯差異,本文選取其均值作為判斷條件。

2 軌跡預測

結合TLD給出的目標位置和圖像采樣頻率,卡爾曼濾波器可預測出目標下一個位置,在下一幀TLD先在預測位置鄰域進行搜索,從而避免無用搜索。具體步驟如下:

(1)用本文提出的目標檢測算法獲得目標初始位置,并初始化TLD和卡爾曼模型;

(2)利用卡爾曼預測法首先在目標鄰域內搜索,再進行其他區域搜索;

(3)判斷TLD目標檢測是否有效,無效進入步驟(4),有效進入步驟(2)迭代計算;

(4)進行全局搜索,判斷是否為目標,如果是進入步驟(2)進行迭代,否則繼續本步驟。

3 實驗結果與分析

本文在硬件參數為4 GB內存、CPU 3.2 GHz頻率下進行實驗。首先使用運動人體檢測算法確定跟蹤目標,如圖5所示。

從圖5中可以看出,該方法正確檢測出人體目標,使用矩形框標出并作為目標。

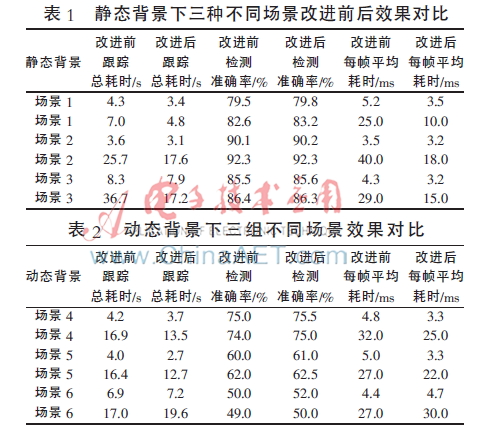

初始化目標后,使用TLD開始跟蹤。為測試改進前后搜索空間減少效果,采集靜態和動態背景下各三種場景。場景1、2、3、4、5、6分別為200、430、1001、456、495、859幀,且都有640×480和1 280×960兩個尺寸,如表1和表2所示。

在靜態背景下,通過引入非線性卡爾曼濾波器進行軌跡預測,通過表1可以看出,其檢測時間縮短,原因是引入卡爾曼進行位置預測,而兩幀之間目標運動幅度較小,因此能夠正確預測,避免了全局空間搜索。在動態背景攝像頭運動軌跡較為平滑的情況下,仍然能正確預測目標下一刻位置,如場景4、5;但當攝像頭運動較為劇烈時則失效,如場景6。這是由于非線性卡爾曼無法處理這種高度非線性情況。

4 結論

本文提出了一種運動人體檢測算法用于自動獲得跟蹤目標,然后在TLD中引入目標軌跡預測指導目標空間搜索,實驗證明該思想能夠減少搜索空間。運動人體檢測通過結合Canny邊緣檢測和混合高斯模型提取較完整的目標輪廓,使用HU仿射不變矩檢測出人體目標,該方法只需幾幀即可自動找到人體目標,適用于靜態和動態背景下單一運動目標實時場景。實驗結論:在攝像頭靜止和緩慢運動情況下,該卡爾曼預測法能夠減少搜索空間;在攝像頭運動較為劇烈情況下,則需要將攝像頭運動信息加入卡爾曼模型,以正確預測目標位置。

參考文獻

[1] DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[J]. Computer Vision and Pattern Recognition (CVPR), 2005(1):886-893.

[2] FELZENSZWALB P, MCALLESTER D, RAMANAN D.A discriminatively trained, multiscale, deformable part model[C]. Computer Vision and Pattern Recognition(CVPR),2008:1-8.

[3] FELZENSZWALB P, GIRSHICK R, MCALLESTER D, et al .Object detection with discriminatively trained part-based models[J]. Pattern Analysis and Machine Intelligence, 2010,32(9):1627-1645.

[4] KALAL Z, MIKOLAJCZYK K, MATAS J, et al. Tracking-Learning-detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011,34(7):1409-1422.

[5] WENG S,KUO C, TU S.Video object tracking using adaptive Kalman filter[J]. Journal of Visual Communication and Image Representation, 2006(17):1190-1208.

[6] 岳佳,王士同.雙重高斯混合模型的EM算法的聚類問題研究[J].計算機仿真,2007,24(11):110-113.

[7] CANNY J. A computational approach to edge detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986,8(6):679-698.

[8] M. K. H.Visual pattern recognition by moment invariants[J]. IRE Transactions on Information Theory,1962,8(2):179-187.