近日,人工智能行業(yè)組織MLCommons發(fā)布了一組新的人工智能績效榜單MLPerf Version 1.1。其中可以看到,其遵循了五個月前的第一套官方基準(zhǔn),包括來自20多個組織的1800多項(xiàng)結(jié)果,以及350項(xiàng)能源效率測量。根據(jù)MLCommons的數(shù)據(jù),大多數(shù)系統(tǒng)的性能比今年早些時候提高了5-30%,其中一些系統(tǒng)的性能數(shù)據(jù)比以前提高了一倍多。在近日宣布一個新的機(jī)器學(xué)習(xí)基準(zhǔn)測試(稱為TCP AIx)之后,出現(xiàn)了新的結(jié)果。

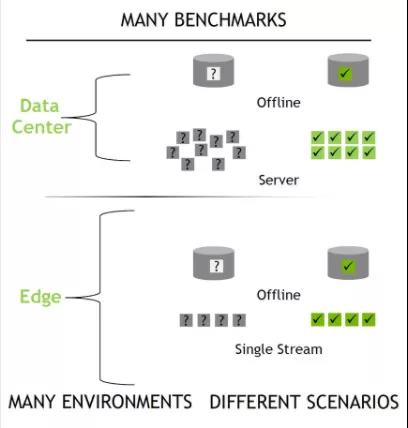

在MLPerf的推斷基準(zhǔn)測試中,由CPU和GPU或其他加速器芯片組合而成的系統(tǒng)在多達(dá)六個神經(jīng)網(wǎng)絡(luò)上進(jìn)行測試,這些神經(jīng)網(wǎng)絡(luò)執(zhí)行各種常見功能:圖像分類、目標(biāo)檢測、語音識別、3D醫(yī)學(xué)成像、自然語言處理和推薦。對于基于商業(yè)數(shù)據(jù)中心的系統(tǒng),他們在兩種條件下進(jìn)行了測試:模擬實(shí)時數(shù)據(jù)中心活動,其中查詢以突發(fā)方式完成;以及“離線”活動,其中所有數(shù)據(jù)一次可用。本應(yīng)在現(xiàn)場工作而不是在數(shù)據(jù)中心工作的計算機(jī)(MLPerf稱之為邊緣)是在離線狀態(tài)下測量的,就像它們接收到單一數(shù)據(jù)流一樣,例如來自安全攝像頭的數(shù)據(jù)流。

盡管有來自戴爾、HPE、浪潮、英特爾、LTech Korea、聯(lián)想、Nvidia、Neuchips、高通和其他公司的數(shù)據(jù)中心級提交,但除高通和Neuchips公司外,其他公司都使用了Nvidia AI加速器芯片。英特爾根本沒有使用加速器芯片,而是單獨(dú)展示其CPU的性能。Neuchips只參與了推薦基準(zhǔn)測試,因?yàn)樗麄兊募铀倨鱎ecAccel專門設(shè)計用于加速推薦電子商務(wù)項(xiàng)目和搜索結(jié)果排名的推薦系統(tǒng)。

MLPerf tests six common AIs under several conditions.NVIDIA

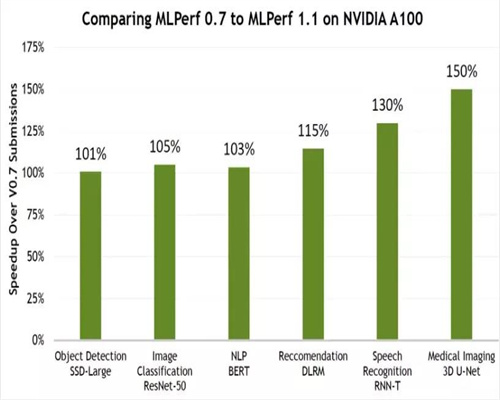

對于Nvidia提交的結(jié)果,該公司僅使用軟件改進(jìn)就彌補(bǔ)了過去一年50%的性能改進(jìn)。測試的系統(tǒng)通常由一個或兩個CPU以及多達(dá)八個加速器組成。在每臺加速器的基礎(chǔ)上,使用Nvidia A100加速器的系統(tǒng)顯示的性能是使用低功率Nvidia A30的系統(tǒng)的兩倍或更多。基于A30的計算機(jī)在服務(wù)器場景的六次測試中,有四次超過了基于高通公司Cloud AI 100的系統(tǒng)。

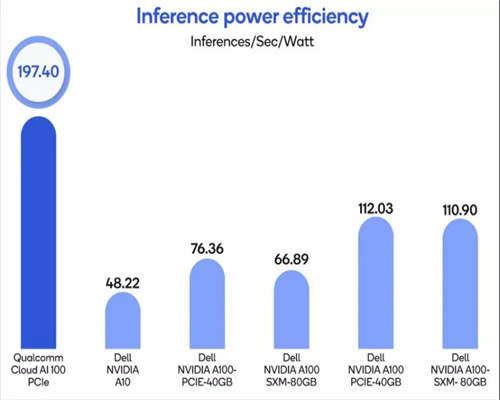

然而,高通公司產(chǎn)品管理高級總監(jiān)John Kehrli指出,高通公司的加速器被故意限制為每個芯片的數(shù)據(jù)中心友好型75瓦功率外殼,但在離線圖像識別任務(wù)中,他們?nèi)匀辉O(shè)法通過了一些基于Nvidia A100的計算機(jī),這些計算機(jī)配備了加速器,每個加速器的峰值熱設(shè)計為400W。

Nvidia has made gains in AI using only software improvements.NVIDIA

Nvidia AI推論高級產(chǎn)品經(jīng)理Dave Salvator指出了該公司加速器的兩個其他結(jié)果:第一,Nvidia A100加速器首次與服務(wù)器級Arm CPU而不是x86 CPU配對。在所有六個基準(zhǔn)測試中,Arm和x86系統(tǒng)之間的結(jié)果幾乎相同。“這對Arm來說是一個重要的里程碑,”Salvator表示,“這也是關(guān)于我們的軟件堆棧準(zhǔn)備就緒,能夠在數(shù)據(jù)中心環(huán)境中運(yùn)行Arm體系結(jié)構(gòu)的聲明。”

與正式的MLPerf基準(zhǔn)測試不同,Nvidia展示了一種稱為多實(shí)例GPU(MiG)的新軟件技術(shù),該技術(shù)允許單個GPU從軟件角度看就像它是七個獨(dú)立的芯片。當(dāng)該公司同時運(yùn)行所有六個基準(zhǔn)測試,再加上一個額外的對象檢測實(shí)例(假設(shè)是flex)時,結(jié)果是單個實(shí)例值的95%。

基于Nvidia A100的系統(tǒng)還清理了邊緣服務(wù)器類別,該類別的系統(tǒng)設(shè)計用于商店和辦公室等場所。這些計算機(jī)按照相同的六個基準(zhǔn)測試中的大部分進(jìn)行測試,但推薦系統(tǒng)被替換為低分辨率的目標(biāo)檢測。但在這個類別中,有更廣泛的加速器可供選擇,包括Centaur的人工智能集成協(xié)處理器;高通公司的AI 100;Edgecortix的DNA-F200 v2,Nvidia的Jetson Xavier和FuriosaAI的Warboy。

Qualcomm topped the efficiency ranking for a machine vision test.QUALCOMM

使用CPU和加速器數(shù)量不同的系統(tǒng),在兩種商業(yè)類別的兩種條件下進(jìn)行六次測試,MLPerf性能結(jié)果實(shí)際上不適用于類似Top500.org通過超級計算實(shí)現(xiàn)的簡單有序列表。最接近的部分是效率測試,可以歸結(jié)為離線組件每瓦特每秒的推斷。高通公司系統(tǒng)在數(shù)據(jù)中心和邊緣類別的對象識別、對象檢測和自然語言處理方面進(jìn)行了效率測試。在每瓦特每秒的推斷方面,他們在機(jī)器視覺測試中擊敗了Nvidia支持的系統(tǒng),但在語言處理方面沒有。Nvidia加速系統(tǒng)占據(jù)了所有其他位置。

近日推出了新的基準(zhǔn),目標(biāo)是一個單一的數(shù)字,這似乎與MLPerf的多維性背道而馳。e Transaction Processing Performance委員會稱TCPx AI基準(zhǔn):

生成和處理大量數(shù)據(jù)

訓(xùn)練預(yù)處理數(shù)據(jù)以生成真實(shí)的機(jī)器學(xué)習(xí)模型

根據(jù)生成的模型對真實(shí)客戶場景進(jìn)行準(zhǔn)確洞察

可以擴(kuò)展到大型分布式配置

允許靈活更改配置,以滿足動態(tài)AI環(huán)境的需求

TPCx人工智能委員會主席兼英特爾首席工程師Hamesh Patel解釋說,該基準(zhǔn)旨在捕獲機(jī)器學(xué)習(xí)和人工智能的完整端到端過程。這包括MLPerf中未包含的流程部分,如準(zhǔn)備數(shù)據(jù)和優(yōu)化。“沒有一個基準(zhǔn)可以模擬整個數(shù)據(jù)科學(xué)管道,”他說。客戶表示,準(zhǔn)備(數(shù)據(jù))可能需要一周時間,訓(xùn)練“神經(jīng)網(wǎng)絡(luò)”可能需要兩天時間。

MLPerf和TPCx AI之間的巨大差異包括后者依賴于與真實(shí)數(shù)據(jù)相似但動態(tài)生成的合成數(shù)據(jù)。MLPerf使用真實(shí)數(shù)據(jù)集進(jìn)行訓(xùn)練和推理,MLCommons執(zhí)行董事David Kanter對合成數(shù)據(jù)結(jié)果的價值表示懷疑。

MLCommons和TPC之間的成員資格有很多重疊,因此,如果兩個基準(zhǔn)中的任何一個在可信度上優(yōu)于另一個,則仍有待觀察。至少兩名MLPerf參與者報告說,MLPerf目前無疑具有優(yōu)勢,計算機(jī)系統(tǒng)制造商已經(jīng)被要求提供MLPerf數(shù)據(jù),作為提案請求的一部分。