大量的數(shù)據(jù)、有效的算法以及足夠的算力結(jié)合,推動(dòng)了人工智能的高速發(fā)展。但我們也不得不看清一個(gè)嚴(yán)峻的現(xiàn)實(shí):數(shù)據(jù)量越來(lái)越大,數(shù)據(jù)類型越來(lái)越多;各種算法日新月異,高速發(fā)展;與此同時(shí),算力的提升卻顯得趕不上趟,甚至落后于數(shù)據(jù)和算法的需求,特別是在計(jì)算場(chǎng)景對(duì)高帶寬、低功耗需求持續(xù)走高的趨勢(shì)下。此外,加之芯片工藝趨近極限,可大規(guī)模商用的新型材料暫時(shí)還沒實(shí)現(xiàn),在芯片架構(gòu)上的探索成為提高芯片性能最重要的手段之一。

AI芯片的破“墻”運(yùn)動(dòng)

在傳統(tǒng)的馮·諾依曼架構(gòu)中,由于計(jì)算與存儲(chǔ)分離,計(jì)算過(guò)程中需要不斷通過(guò)總線交換數(shù)據(jù),將數(shù)據(jù)從內(nèi)存讀進(jìn)CPU,計(jì)算完成后再寫回存儲(chǔ)。而隨著深度學(xué)習(xí)的發(fā)展和應(yīng)用,計(jì)算單元和存儲(chǔ)單元之間的數(shù)據(jù)移動(dòng)尤為頻繁,數(shù)據(jù)搬運(yùn)慢、搬運(yùn)能耗大等問(wèn)題成為了算力效能進(jìn)一步提升的關(guān)鍵瓶頸。從處理單元外的存儲(chǔ)器提取數(shù)據(jù),搬運(yùn)時(shí)間往往是運(yùn)算時(shí)間的成百上千倍,公開數(shù)據(jù)顯示,整個(gè)過(guò)程的無(wú)用能耗約在60%-90%之間。

特別是大算力場(chǎng)景下,存算分離帶來(lái)的計(jì)算帶寬問(wèn)題成為主要瓶頸。以智能駕駛等邊緣端高并發(fā)計(jì)算場(chǎng)景來(lái)看,它們除了對(duì)算力需求高之外,對(duì)芯片的功耗和散熱也有很高的要求。而常規(guī)架構(gòu)的芯片設(shè)計(jì)中,內(nèi)存系統(tǒng)的性能提升速度已經(jīng)大幅落后于處理器的性能提升速度,有限的內(nèi)存帶寬無(wú)法保證數(shù)據(jù)高速傳輸,無(wú)法滿足高級(jí)別的計(jì)算需求。

行業(yè)面臨的挑戰(zhàn)很突出,一邊是需要逾越的“算力高墻”,一邊則是固守多年的“存儲(chǔ)墻”。而只有創(chuàng)新架構(gòu),打破存儲(chǔ)墻、降低成本、提升計(jì)算效率,才能讓芯片算力更進(jìn)一步,推進(jìn)數(shù)據(jù)計(jì)算應(yīng)用的發(fā)展。

在這一趨勢(shì)下,將內(nèi)存和計(jì)算更緊密地結(jié)合在一起的存算一體方案,正獲得越來(lái)越多的關(guān)注,并逐步由研究走入商用場(chǎng)景中。

以數(shù)據(jù)為核心的AI芯片路線

對(duì)于大算力的AI芯片來(lái)說(shuō),架構(gòu)設(shè)計(jì)已經(jīng)越來(lái)越明顯地轉(zhuǎn)向了“數(shù)據(jù)為核心”的思路,不過(guò)對(duì)于不同技術(shù)路線的企業(yè)來(lái)說(shuō),有不同的實(shí)現(xiàn)方式。

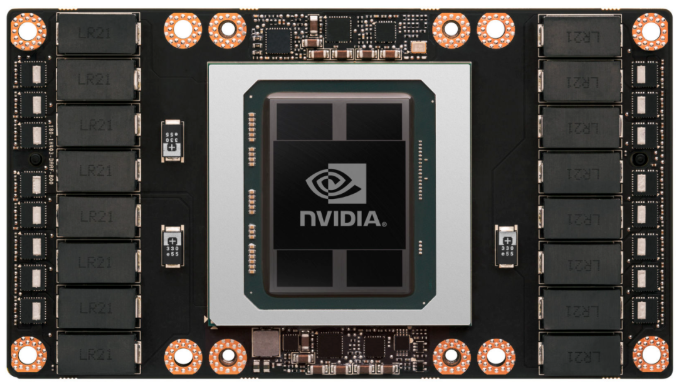

圖源 | VideoCardz

HBM是目前超大算力芯片常用的方案之一,它能夠暫時(shí)緩解“存儲(chǔ)墻”的困擾,但實(shí)現(xiàn)成本較高。以英偉達(dá)在AI云端市場(chǎng)大規(guī)模落地的GPU來(lái)看,其最先進(jìn)的Hopper架構(gòu)一方面通過(guò)HBM來(lái)解決內(nèi)存墻,另一方面新增了張量存儲(chǔ)加速器 (TMA) 。整個(gè)Hopper架構(gòu)GPU由8個(gè)圖形處理集群(GPC)“拼接”組成,核心兩側(cè)是HBM3顯存,擁有5120 Bit的位寬。此外,TMA提高了張量核心與全局存儲(chǔ)和共享存儲(chǔ)的數(shù)據(jù)交換效率。

這一方式也需要先進(jìn)的工藝和封裝技術(shù),基于Hopper的最新一代GPU H100,就采用了臺(tái)積電4nm工藝、CoWoS 2.5D封裝技術(shù),在設(shè)計(jì)能力、成本投入方面都有很高門檻。

再看三星發(fā)布的HBM2-PIM技術(shù)和近內(nèi)存計(jì)算方案AxDIMM。HBM2-PIM實(shí)際上是一塊帶有計(jì)算功能且在AI應(yīng)用中能提升系統(tǒng)性能的內(nèi)存芯片,AxDIMM則實(shí)現(xiàn)了在每個(gè)DRAM芯片旁邊都集成了一塊單獨(dú)的加速器邏輯并可以同時(shí)訪問(wèn),增加了訪存帶寬。這樣的設(shè)計(jì)思路也非常符合三星的業(yè)務(wù)規(guī)劃,用以確保其存儲(chǔ)器在AI時(shí)代繼續(xù)保持先進(jìn)性。

英特爾的神經(jīng)擬態(tài)計(jì)算芯片Loihi也采用了存算一體的架構(gòu),使之更加容易擴(kuò)展。Loihi芯片的裸片包含128個(gè)小核,每個(gè)核里面模擬1024個(gè)神經(jīng)元的計(jì)算結(jié)構(gòu),每個(gè)神經(jīng)元又有1000個(gè)突觸連接,這意味著768個(gè)芯片連接起來(lái)可以構(gòu)建接近1億神經(jīng)元的系統(tǒng)。

存算一體,方興未艾

近年來(lái),國(guó)內(nèi)企業(yè)對(duì)于存算一體芯片的投入進(jìn)入高峰期。

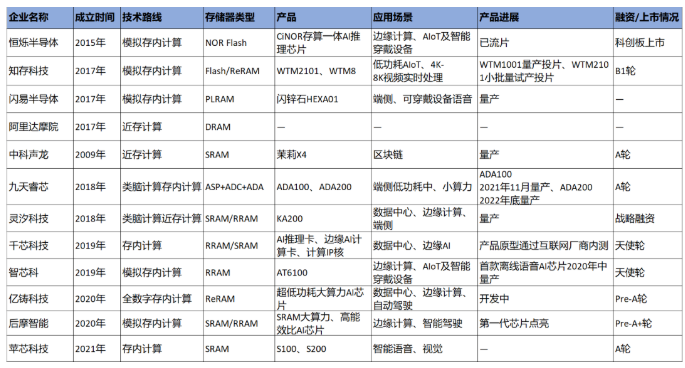

據(jù)<與非網(wǎng)>分析,國(guó)產(chǎn)存算一體芯片主要呈現(xiàn)以下趨勢(shì):進(jìn)入2017年以來(lái),國(guó)產(chǎn)存算一體芯片企業(yè)開始“扎堆”入場(chǎng),12家企業(yè)中有10家成立于2017年之后;第二,從技術(shù)路線來(lái)看,以近存計(jì)算和存內(nèi)計(jì)算兩種路線為主,其中,又可以細(xì)分為模擬存內(nèi)計(jì)算、全數(shù)字存內(nèi)計(jì)算、類腦存內(nèi)計(jì)算、類腦近存計(jì)算等;第三,存儲(chǔ)器類型相對(duì)多樣化,包括閃存、SRAM、RRAM、ReRAM等;第四,國(guó)產(chǎn)存算一體芯片正在向大算力的方向邁進(jìn),以2020年成立的億鑄科技和后摩智能為代表。

圖:國(guó)產(chǎn)存算一體芯片概況

<與非網(wǎng)>不完全整理

技術(shù)路線的選擇直接決定了產(chǎn)品的應(yīng)用方向。近存計(jì)算的基本做法是將數(shù)據(jù)存儲(chǔ)盡量靠近計(jì)算單元,降低數(shù)據(jù)搬運(yùn)的延遲和功耗,其架構(gòu)主要包括多級(jí)緩存架構(gòu)和高密度片上存儲(chǔ);而存內(nèi)計(jì)算是對(duì)內(nèi)部存儲(chǔ)中添加計(jì)算邏輯,直接在內(nèi)部存儲(chǔ)執(zhí)行數(shù)據(jù)計(jì)算,這種架構(gòu)數(shù)據(jù)傳輸路徑最短,同時(shí)能滿足大模型的計(jì)算精度要求。

在存儲(chǔ)器的選擇方面,發(fā)展較為成熟的有NOR Flash、SRAM、DRAM等。FLASH屬于非易失性存儲(chǔ)介質(zhì),具有低成本、高可靠性優(yōu)勢(shì),但工藝制程有瓶頸;SRAM在速度方面有優(yōu)勢(shì),但容量密度小,價(jià)格高,在大陣列運(yùn)算的同時(shí)保證運(yùn)算精度具有挑戰(zhàn);DRAM成本低、容量大,但是速度慢,且需要電力不斷刷新。存算一體新型存儲(chǔ)器有PCRAM、MRAM、ReRAM等,其中ReRAM在神經(jīng)網(wǎng)絡(luò)計(jì)算中具有優(yōu)勢(shì),是目前發(fā)展較快的新型存儲(chǔ)器。

此外,還有模擬存算和全數(shù)字存算的區(qū)分。究竟是數(shù)字好還是模擬好?前幾年,業(yè)界認(rèn)為模擬計(jì)算在速度、能耗、工藝節(jié)點(diǎn)方面有優(yōu)勢(shì);近些年,又提出模擬路線需要進(jìn)行模數(shù)轉(zhuǎn)換,精度容易受信噪比影響達(dá)到上限,而數(shù)字計(jì)算具有高精度、高環(huán)境容忍度的優(yōu)點(diǎn)。不過(guò),不論是模擬還是數(shù)字,都需要企業(yè)基于已有技術(shù)能力,面向應(yīng)用場(chǎng)景、可選擇工藝等方面進(jìn)行權(quán)衡選擇。

誰(shuí)將勝出?

面向國(guó)際巨頭在AI算力市場(chǎng)、存儲(chǔ)技術(shù)占據(jù)領(lǐng)先地位的當(dāng)下,以電路/架構(gòu)設(shè)計(jì)出身的存算一體初創(chuàng)公司,將競(jìng)爭(zhēng)核心著眼于存算一體SoC芯片設(shè)計(jì)以及相應(yīng)的IP核能力,是一種較為務(wù)實(shí)的做法。并且,差異化的技術(shù)路線演進(jìn),長(zhǎng)遠(yuǎn)看也有利于產(chǎn)業(yè)的良性發(fā)展。

目前看來(lái),整個(gè)行業(yè)對(duì)存算一體芯片的研究依舊處于探索階段,在工藝成熟度、典型應(yīng)用、生態(tài)系統(tǒng)等方面亟待進(jìn)一步成熟,談?wù)撃姆N架構(gòu)勝出為時(shí)尚早。并且,存算一體芯片發(fā)展本身就涉及龐雜的產(chǎn)業(yè)鏈環(huán)節(jié),需要從存儲(chǔ)器到AI芯片再到編譯器和算法的一系列技術(shù)能力,也離不開強(qiáng)大的開發(fā)能力和生態(tài)建設(shè)能力。

寫在最后

多年從事芯片開發(fā)的工程師,到后來(lái)可能發(fā)現(xiàn),很多時(shí)候算力的提升并不在于計(jì)算單元本身,而是傳輸帶寬的制約。對(duì)于這一多年來(lái)就存在的瓶頸,存算一體無(wú)疑是合理的路徑,也因深度學(xué)習(xí)的興盛而達(dá)到了合適的發(fā)展節(jié)點(diǎn)。

目前看來(lái),第一批實(shí)現(xiàn)量產(chǎn)落地的存算一體芯片,以小算力、端側(cè)應(yīng)用居多,面向大算力數(shù)據(jù)中心、智能駕駛的芯片,根據(jù)主要玩家的市場(chǎng)規(guī)劃,有望在未來(lái)一兩年內(nèi)實(shí)現(xiàn)量產(chǎn)。

在人工智能本身仍在探尋應(yīng)用場(chǎng)景的前提下,存算一體化的落地問(wèn)題,仍需要緊密結(jié)合具體應(yīng)用場(chǎng)景具體分析。存算一體芯片產(chǎn)業(yè)真正走向成熟還需要持續(xù)地積累,實(shí)現(xiàn)小算力場(chǎng)景持續(xù)滲透,針對(duì)高價(jià)值場(chǎng)景做極致優(yōu)化;大算力場(chǎng)景規(guī)模量產(chǎn),最終走向普遍應(yīng)用。

更多信息可以來(lái)這里獲取==>>電子技術(shù)應(yīng)用-AET<<