0 引言

隨著多媒體技術及寬帶網絡傳輸技術的發展,視頻采集及傳輸系統作為遠程視頻監控、可視電話會議和工業自動控制領域的一項核心關鍵技術,近年來也得到了飛速的發展。本文所提出的系統是在新一代基于ARM926EJ-S微處理核的嵌入式開發平臺上進行的,并將國際上流行的MPEG-4壓縮編解碼技術和流媒體傳輸技術相結合。該系統具有較強的實時性、可交互性及便攜性。

1 系統開發硬件平臺

本設計采用的開發平臺是Freescale i.MX家族的MC9328MX21,作為整個系統的核心微處理器,其ARM926EJ-S核提供了加速的Java支持和高度整合的系統功能模塊,如片上模塊包括圖像加速模塊、LCD控制器、USB控制模塊、CMOS傳感器接口及同步串口等,為開發者進行多媒體應用開發提供了豐富的外圍接口。核心板上集成了64MB SDRAM以及16MBFlash存儲器,底板資源包括4個四線RS-232串口、1個10 Mbit·s-1/100 Mbit·s-1自適應以太網接口及音視頻采集設備,為系統設計時的交叉編譯及多媒體數據的處理提供了方便。

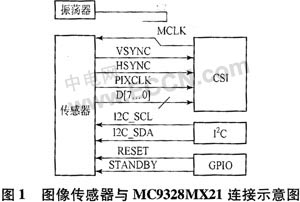

系統的關鍵外圍設備、視頻數據的采集所使用的CMOS圖像傳感器OV9640,與傳統的CCD圖像傳感器相比,具有功耗低、體積小、集成度高等優點,并且OV9640支持VGA、QVGA、CIF等多種解析度,支持的數據格式包括YCrCb 4:2:2、GRB 4:2:2和RGB:RawData這3種,圖像幀傳輸速率達30幀/s。傳感器通過CSI模塊進行圖像數據的采集,然后通過專用總線傳輸至PRP(eMMA Pre-processor),在PRP中調整圖像大小并轉換成合適的顏色空間。PRP的輸出分成2個通道,通道1輸出RGB565格式數據作為LCD的顯示,通道2輸出YUV420格式數據進行MPEG或者JPEG編碼。圖1是圖像傳感器和MC9328MX21的連接原理圖。

在兩者連接中,各模塊端口的作用分別是:CSI端口為傳輸圖像數據;I2C端口為配置傳感器;GPIO為控制傳感器。

MC9328MX21的CSI模塊有一個8位輸入端口,如果傳感器的傳輸超過8位數據,圖像傳感器通常作為從設備通過I2C端口控制。底層的協議是I2C,高層的協議則由傳感器確定。在這里,圖像傳感器的主時鐘由MC9328MX21提供。

2 系統的軟件系統設計

2.1 搭建交叉編譯環境

由于嵌入式系統選用的是開源的基于ARM微處理器的系統內核ARM-Linux,而在開發板上沒有足夠的資源運行開發調試工具,所以必須首先搭建好交叉編譯調試環境。首先,需要通過在編譯時指定target=arm-linux生成適合ARM平臺的binutils,它包括了ld、ar和as等一些生成和處理二進制文件的工具。然后,編譯生成GCC(GNU Compiler Collection),它能夠支持多種高級語言,如C,C++等,需要注意的是,在編譯GCC時需要ARM-linux內核頭文件的支持,所以首先需要配置內核#make menuconfig ARCH=ARM來生成對應ARM內核的頭文件,這樣就可以在配置編譯GCC時通過with-headers選項指定編譯所需頭文件。最后,還需要編譯生成許多用戶層應用都要用到的函數庫glibc,所有動態鏈接的程序都要用到它,在編譯時需要注意的是打開--enable-add-ons選項,這個開關將打開glibc的附加包,因為我們需要用到linu-xthreads。這樣,一個嵌入式ARM-linux下的交叉編譯環境就已搭建成功。

2.2 編譯制作內核及文件系統

通過make menuconfig配置內核選項,其中的一些關鍵設置包括指定System Type時打開ARM926T CPUidle、I-Cache 0n和D-Cache,并且由于在進行應用軟件開發時需要ARM-linux內核支持frame buffer技術,所以還需要打開Console drivers中的Frame-buffer sup-port。然后,make boot就可以編譯生成定制好的內核映像文件Image,將制作好的系統內核和文件系統通過宿主機的TFTP服務燒寫進開發板的Flash存儲器。這樣就完成了板上可獨立運行的操作系統的設計。

2.3 視頻數據的采集、編碼和傳輸的實現

這部分的工作是整個設計的核心。MPEG-4在1999年初正式成為國際標準,與之前的標準相比,它更加重視多媒體系統的交互性和靈活性,主要針對視頻會議、可視電話的超低比特率編碼等多媒體應用。目前在嵌入式系統中,MPEG-4編解碼主要都是通過專用芯片實現的,其實現方法與MPEG-1、MPEG-2的硬件實現方法類似,將編碼算法固化在芯片的硬件電路中,所以導致它在使用中存在以下缺點:

a) 性價比不高。由于現在MPEG-4編碼技術還在不斷發展中,還沒有一個真正成熟的算法支持,所以市場上推出的MPEG-4編碼芯片都是在標準基礎上進行了修改和簡化,在性能上與H.263等編碼芯片上沒有明顯的優勢,所以其性價比不高。

b) 可移植性差。由于各廠商所生產的編碼芯片都在固化時加入了自己對編碼算法的改進和優化,所以在解碼端必須使用對應的專用解碼器,這就導致出現了兼容性的問題。

c) 無可擴展性。隨著對MPEG-4編解碼標準的研究,必然提出許多新的算法及對原有算法的改進,但是現有的MPEG-4編碼芯片已將已有的算法固定在了芯片硬件電路中,所以無法方便地在芯片上進行算法的修改及擴展。

所以在設計該系統時,主要采用了軟件實現其編解碼,在嵌入式系統中采用軟件實現編解碼,可以彌補硬件編解碼上的諸多不足,而且便于對算法本身進行研究和改進。但是,也需要考慮幾個問題:首先,由于MPEG-4編碼算法運算量復雜,而嵌入式系統的資源有限,所以必須考慮所選平臺微處理器的運算能力;其次,在編碼軟件及數據采集硬件的接口部分,由于需要針對不同的采集硬件,所以需要做許多匯編級的優化。

FFMPEG是一個音視頻數據的采集記錄、編碼及流式傳輸的完全解決方案。該項目包括下面組件:

a) FFMPEG是音視頻文件格式轉換的命令行方式的工具,同時支持實時的采集編碼TV card數據。

b) FFserver可以通過HTTP/RTSP方式進行多媒體數據的流式播放。

c) FFplayer是基于FFMPEG庫和SDL的播放器。

d) libavcodec包括了全部FFMPEG音視頻的編解碼庫,libavformat包括了全部支持的音視頻格式的語法和生成庫。

FFMPEG庫支持的編解碼支持格式非常豐富,而且編解碼速度很快;支持指定音視頻捕捉設備實時處理數據源并將其存;FFMEPG能夠通過命令行參數指定視頻編解碼、格式轉換的幀頻、幀大小及比特率、碼率控制緩沖區的大小;并且,FFMPEG可以通過激活視頻的高級選項來對編解碼的方式進行控制,包括設置幀內編碼、視頻量化標度的設置、設定p幀以及b與i幀間的qp因子和偏差、運動估計及DCT/IDCT算法的選擇,b幀和運動矢量以及交織編碼方式的使用。對于視頻捕捉設備的選擇也可以通過參數來選定,如/dex/video0或DV1394專用通道等。

FFMPEG庫能夠在多種平臺上運行,包括Linux、Windows和Mac OS等系統,在嵌入式系統中,由于嵌入式Linux具有源代碼完全開放、可移植性強和對網絡的支持好等特點,所以選用了ARM-Linux系統,該系統支持這次選用的ARM9架構的CPU,而FFMPEG是針對通用PC的X86架構的CPU設計的,因此要將FFMPEG移植到ARM9架構的系統上。首先需要通過將其交叉編譯成可在ARM-linux上運行的庫。具體步驟如下。

將下載的最新的FFMPEG源代碼包解壓縮再生成FFMPEG目錄,然后針對所開發系統的交叉編譯鏈,通過修改configure文件來生成Makefile文件, 然后用make命令通過讀取生成的Makefile文件來自動編譯生成所需要的FFMPEG庫文件和可以在ARM開發板上運行的二進制可執行文件。編譯成功以后就可以通過宿主機的NFS服務將宿主機安裝到開發板上,這樣就可以到相關目錄下測試所編譯的FFMPEG能否正常地工作:

![]()

即將對音頻文件cat.wav和原始的yuv視頻文件編碼生成cat.mpg,如果沒有輸入數據文件,則音視頻捕捉設備就將起作用,說明所需要的交叉編譯生成的FFM-PEG庫可以正確地運行。

2.4 視頻采集編碼程序的關鍵技術

在設計視頻采集程序時主要使用FFMPEG的libavformat和libavcodec這兩個函數庫,許多視頻文件格式一般只是定義如何將音視頻流編碼進一個獨立的文件,而不明確指出其使用的編碼工具,libavformat庫的功能主要是分析視頻文件的語法格式,并將它從流中分離出原始的音視頻流,libavcodec庫的功能則是按照流格式處理原始的音視頻流編解碼。

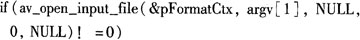

在使用libavformat/libavcodec庫函數對視頻文件進行處理時,首先通過調用av_register_all()函數對其初始化,這個函數中定義了所有庫所能支持的文件格式和編碼器,因此當讀取一個文件時,通過調用此函數來自動使用所對應的格式或者編碼庫。視頻文件打開則通過av_open_input_file函數來實現:

這個函數的最后3個參數分別定義了文件的格式、緩沖區的大小和格式的參數;在這里賦值NULL和0來指定libavformat庫函數自動檢測格式和使用默認的緩沖區的大小。然后就可以讀取文件的流信息:

![]()

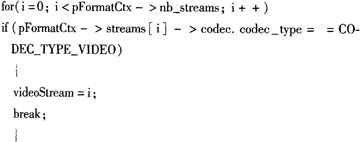

來填充AVFormatContext中關于流區域的內容,接著通過一個循環尋找到第1段視頻流:

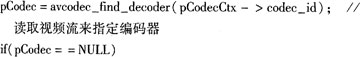

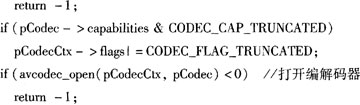

這樣就可以讀取視頻流的內容來指定選用的編解碼器并將編解碼器打開:

這里的定義CODEC_CAP_TRUNCATED是指當視頻流被分割成小的數據包以后,由于每一幀視頻的數據量會發生變化,這就需要兩個視頻幀的邊緣與數據包的邊緣匹配,因此在這里定義這個宏來告訴編碼器該如何處理它。最后調用avcodec_alloc_frame()函數來分配幀緩沖。

在編碼端需要使用libavformat庫函數來讀取這些數據包,濾除掉不需要的非視頻流數據,然后循環調用libavcodec庫函數GetNextFrame(AVFormatContext *pFormatCtx,AVCodecContext * pCodecCtx,int video-Stream,AVFrame * pFrame)來處理每幀數據進行編解碼。

視頻采集端采用從Video4Linux視頻設備源中捕捉視頻幀,Video4Linux是Linux下用于獲取音頻和視頻的API接口,現有的Video4Linux有v41和v412兩個版本,我們采用v4l進行編程,在Linux下,將所有外沒都看做一種特殊的文件,稱之為設備文件,因此利用v4l API獲取視頻圖像可以通過調用open、ioctl等函數,像對普通文件一樣對硬件進行初始化、設置硬件屬性和調用硬件中斷等操作。在打開視頻采集設備后,分別通過ioctl(vd->fd,VIDIOCGCAP,&(vd->ca-pability))函數的VIDIOCGCAP控制命令,來獲取關于視頻采集設備所能顯示的最大圖像大小,信號源的通道數和通過ioctl(vd->fd,VIDIOCGPICT,&(vd->picture))的VIDIOCGPICT來獲取一些關于圖像的亮度、對比度等信息。Video4Linux方式獲取視頻圖像的方式有overlay和mmap兩種,在這里采用了MMAP方式,MMAP方式允許直接將設備內存映射到用戶進程的地址空間中,這樣就可以直接在進程中讀寫內存來控制設備。在使用libavformat/libavcodec庫從Vide-o4Linux視頻設備源中捕捉視頻幀時需要調用av_open_input_file()函數,因此,最后還需要修改此函數中的設備屬性配置,使之與我們所選用的沒備相對應。

3 測試結果及展望

在這里使用了ffserver流媒體服務端組件來實現流媒體傳輸,首先需要配置ffserver.conf文件中關于服務端主機的端口號、傳輸帶寬、延遲,流媒體文件屬性等信息。然后啟動ffserver讀取配置文件,就可以在接收端通過WMP(Windows Media Player)輸入服務端URL看到實時采集的視頻圖像。經測試,目前該嵌入式流媒體服務器在傳輸MPEG-4視頻時的幀率可以達到20幀/s,接收端觀察圖像流暢,畫面清晰。

本文提出了一種基于ARM9架構MC9328MX21的嵌入式系統上實現MPEG-4流媒體視頻采集傳輸系統,通過在ARM-Linux操作系統下移植libavformat/libavcode庫,利用該函數庫良好的可移植性和Video4Linux完成了本地視頻圖像的采集、編碼等功能,并向網絡發送流媒體打包數據。該系統具有實時性好、可移植性強、低功耗和可遠程移動控制嵌入式系統的特點,并且采用軟件實現其主要功能,有利于系統的二次開發及升級,其應用范圍和前景將非常廣闊。